情報エントロピー(information entropy)とは、特定の事象の組み合わせに基づいて、各事象の情報量の平均を示す概念です。

この指標は、統計力学におけるエントロピーの考え方に似ており、事象の不確かさや無秩序さを表現します。

本記事では、情報エントロピーの定義、計算方法、そして実際の応用について詳しく解説します。

情報エントロピーの定義

1. 情報量の概念

情報エントロピーは、事象の発生確率に基づいて定義されます。

具体的には、特定の事象が起こる確率が高いほど、その情報は低く評価されます。

逆に、発生確率が低い事象は高い情報量を持ちます。

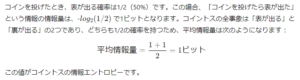

例: コイントス

2. エントロピーの計算

情報エントロピーの重要性

1. 不確かさの測定

情報エントロピーは、システム内の不確かさを定量的に測るための有効な手段です。

たとえば、必ず表しか出ないように加工されたコインを投げる場合、表が出る確率は100%で、裏が出る確率は0%です。

この場合、情報量は0ビットとなり、エントロピーも0ビットになります。

つまり、事象の不確かさが完全に失われていることを示しています。

2. 通信やデータ圧縮への応用

情報エントロピーの概念は、データ圧縮や通信の効率化にも利用されます。

エントロピーが高いデータは圧縮が難しい一方、低いエントロピーを持つデータは圧縮が容易です。

この特性を活かして、エントロピーに基づいた圧縮アルゴリズムが開発されています。

まとめ

情報エントロピーは、事象の不確かさや情報量を定量的に評価するための重要な指標です。

コイントスの例を通じて、その計算方法や意味を理解することができました。

今後、データ圧縮や通信の分野での応用が期待されるこの概念は、情報理論の基礎を成すものです。

情報エントロピーを理解することで、より効率的なデータ処理や管理が可能になります。

さらに参考してください。

プリンタージャムの原因と対策:紙詰まりを解消する方法

Rate this post

Visited 1 times, 1 visit(s) today