半精度浮動小数点数型(half-precision floating point number type)は、主に機械学習や3DCG処理といった高パフォーマンスが求められるIT分野で急速に採用が進んでいるデータ型です。

従来の32ビットや64ビットの浮動小数点数に比べ、記憶容量を大幅に節約しつつ、計算負荷を軽減できることから、今後の開発現場での重要性が高まっています。

この記事では、半精度浮動小数点数型の構造、メリット、実際の利用シーン、そして技術的な背景について詳しく解説します。

半精度浮動小数点数型とは?

基本定義

半精度浮動小数点数型とは、16ビット(2バイト)のサイズを持つ浮動小数点数のデータ型です。

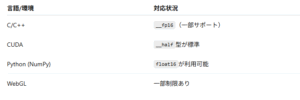

プログラミング言語やハードウェアアーキテクチャによっては、「half」「fp16」「binary16」といった表記が使われます。

このデータ型は、IEEE 754規格における「binary16」形式に準拠しており、十進数でおよそ -65,504 〜 +65,504 の範囲の数値を、約3桁の精度で表現できます。

データ構造の内訳

IEEE 754のbinary16形式におけるビット構成は次の通りです:

-

1ビット:符号部(正負を表す)

-

5ビット:指数部(スケーリング情報)

-

10ビット:仮数部(精度)

この仮数部には、「ケチ表現(implicit leading bit)」が採用されており、仮数の先頭の1ビット(常に1であることが前提)を省略することで、実質的には11ビット相当の精度を確保しています。

なぜIT業界で注目されるのか?

メモリと処理速度の最適化

従来の32ビット(単精度)や64ビット(倍精度)の浮動小数点数型に比べて、半精度浮動小数点数型はメモリ使用量が半分以下。

この利点は以下のような分野で特に活きてきます:

-

ディープラーニング:GPUメモリの節約による高速学習

-

3Dゲームエンジン:リアルタイムレンダリング処理の軽量化

-

組込みシステム:限られたハードウェアリソースでの高効率演算

たとえば、NVIDIAのTensor Coreは、半精度(FP16)演算に最適化されており、全精度(FP32)よりも数倍高速な処理が可能となっています。

活用シーンと実装例

機械学習におけるFP16の役割

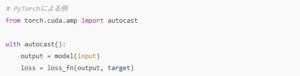

TensorFlowやPyTorchといった主要な深層学習フレームワークでは、モデルの学習をFP16で行う「mixed precision training」が推奨されています。

このようにFP16を活用することで、メモリ使用量を削減しつつ、学習速度を向上させることが可能です。

3Dグラフィックス処理での利点

たとえばUnityやUnreal Engineなどのゲームエンジンでは、シェーダーや頂点データの格納に半精度型を用いることで、グラフィックス処理を高速化できます。