ビット(bit)は、コンピュータやネットワーク、あらゆるデジタル処理の基本を支える情報の最小単位です。日常的に使われる「メガビット」「ギガビット」といった言葉のルーツでもあり、あらゆるITシステムで使われるデータの土台といえます。

この記事では、ビットの定義や仕組み、計算方法、バイトやbpsとの関係、そして現代のIT環境における応用例までを詳しく解説し、理解を深めていきます。

ビットとは何か?

ビット(bit)の定義

ビットとは、binary digit(バイナリーディジット)の略語で、「0」か「1」のどちらかを表す二進数の1桁を意味します。

これは、コンピュータが電気信号のオン(1)・オフ(0)で情報を処理するという仕組みに由来しています。

例:1ビット = コインの表裏、スイッチのON/OFF、YES/NO のような「2択の情報」

複数ビットによる情報表現の拡張

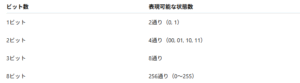

nビットで表現可能な状態数

ビットは複数組み合わせることで、より多くの情報を表現可能になります。

基本的な考え方は「2のn乗(2ⁿ)」です。

例えば、英語の大文字アルファベット(A〜Z)26文字を識別するには、最低でも5ビット(32通り)が必要です。

バイトとの関係と実用性

バイト(byte)との違い

1バイト = 8ビットが基本的な定義です。

ビット単位では扱いにくいため、実用上はバイトでデータ容量やサイズを表現することが一般的です。

例:

-

1バイト = 「A」などの1文字

-

4バイト = 32ビット整数(int型などの整数値)

-

8バイト = 64ビット浮動小数点数(double型など)

ビット単位の転送速度:bps

bps(bit per second)は、ネットワークなどのデータ転送速度を表す単位です。

例:

-

100Mbps = 1秒間に1億ビットを転送可能

-

1Gbps = 高速光回線の通信速度レベル

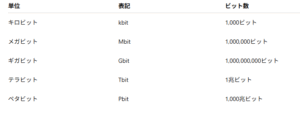

ビットの倍量単位

SI接頭辞による表現

IECによる2進系接頭辞(記憶装置などに多い)

このような2進専用の接頭辞は、記憶媒体の表記やOSのファイルサイズ管理において重要です。

ITにおけるビットの具体的な活用例

プログラミングでのビット操作

-

ビット演算:AND(&)、OR(|)、NOT(~)、XOR(^)、シフト演算(<<, >>)などで、高速かつ効率的な処理が可能。

-

フラグ管理:複数の状態を1つの整数に格納し、オン/オフの管理に利用されます。

例(C言語風):

![]()