ビットパターン(bit pattern)は、ITやコンピュータにおいて非常に基本的かつ重要な概念のひとつです。

デジタルデータはすべて、「0」と「1」で構成されるビット列によって表現され、その並び方=ビットパターンによって意味や値が決まります。

本記事では、ビットパターンの定義やその数え方、さらに実際のIT分野での応用例について、専門的な視点から詳しく解説します。

ビットパターンの基礎知識

ビットパターンとは何か?

ビットパターンとは、固定長のビット列における「0」と「1」のすべての組み合わせを指します。

たとえば、3ビットの長さであれば、次のような8通りのビットパターンが存在します:

-

000

-

001

-

010

-

011

-

100

-

101

-

110

-

111

このように、nビット長のビット列では2ⁿ通りのビットパターンが存在します。

これは指数的に増加するため、ビット数が増えるほど、表現できる情報量が急激に増えるのが特徴です。

ビットとビット列の関係

ビット(bit)は、コンピュータにおける最小の情報単位で、1ビットは「0」または「1」のどちらかの値を取ります。

複数のビットを並べて一列にしたものがビット列(bit string)であり、このビット列が意味を持つ形として認識されるのがビットパターンです。

ビットパターンの組み合わせ数

ビット数とそれに対応するパターン数の関係は以下の通りです:

この仕組みは、メモリ容量の計算や符号化理論、データ圧縮、通信プロトコル設計などにも利用されています。

ビットパターンの具体的な応用例

文字コードの表現

たとえば、アルファベットの大文字26文字をすべてビットで表す場合、4ビット(16通り)では不足するため、最低でも5ビット(32通り)が必要になります。

これはASCIIコードやUnicodeなど、文字コード設計の際に不可欠な計算です。

![]()

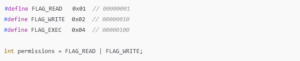

ビットマスクとフラグ管理

システムプログラミングや組み込み開発では、複数の状態を1つの数値として管理するためにビットパターンを使います。これをビットマスクと呼びます。