活性化関数(activation function)は、ニューラルネットワークの各ニューロンでの情報処理において不可欠な役割を果たします。

この関数は、入力値に対して非線形な変換を施し、次の階層のニューロンに出力するための鍵となる要素です。

本記事では、活性化関数の概要、主要な種類、そしてその実際の応用例について詳しく解説します。

活性化関数の基本

H2: 活性化関数とは?

活性化関数は、人工ニューラルネットワーク(ANN)において、ニューロンが入力信号を受け取った後、その信号に対して適用される数学的関数です。

この関数は、各ニューロンからの出力を決定し、下層のニューロンへの信号伝達を行います。

H2: なぜ活性化関数が必要か?

ニューラルネットワークでは、単純な線形変換を繰り返すだけでは、深層学習の効果が得られません。

活性化関数は、非線形変換を導入することで、複雑なデータのパターンを学習できるようにします。

活性化関数の種類

H2: 主な活性化関数

以下は、よく使われる活性化関数の種類とその特性です。

H3: ステップ関数

初期の研究で使用されたこの関数は、特定の閾値を超えると出力が「1」となり、そうでなければ「0」を返します。

シンプルですが、微分可能ではないため、バックプロパゲーションには不向きです。

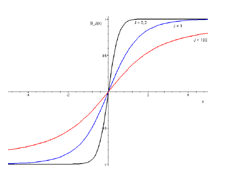

H3: シグモイド関数

この関数は、出力が0から1の間で滑らかに変化します。

微分可能であるため、学習過程で広く使用されてきましたが、勾配消失問題に悩まされることがあります。

H3: tanh関数(双曲線正接関数)

tanh関数は、出力が-1から1の範囲に収束します。

シグモイド関数と比べて勾配が強いため、より良い学習結果をもたらすことが多いです。

H3: ReLU(Rectified Linear Unit)

ReLUは、基準値以下では0、基準値以上では入力値そのものを出力する関数です。

計算が簡単でありながら、学習が早いため、現代の深層学習モデルで非常に人気があります。

H3: Softplus

ReLUを滑らかにしたバージョンで、出力が常に正であることが保証されています。

非線形性がありつつも、微分可能です。

活性化関数の選択と応用

H2: どの活性化関数を選ぶべきか?

活性化関数の選択は、モデルの性能に大きな影響を与えます。

例えば、画像認識や音声認識などの複雑なタスクでは、ReLUやその変種が好まれます。

一方で、出力層では、分類問題においてSoftmax関数を使用することが一般的です。

H2: 実際の応用例

例えば、画像認識におけるCNN(畳み込みニューラルネットワーク)では、各層にReLUを使用することで、非線形性を持たせながら効率的に学習を進めます。

また、自然言語処理においては、LSTM(Long Short-Term Memory)やGRU(Gated Recurrent Unit)などの再帰型ネットワークでも活性化関数は重要な役割を果たします。

まとめ

活性化関数は、ニューラルネットワークにおける重要な構成要素であり、非線形変換を通じてモデルの学習能力を向上させます。

さまざまな活性化関数が存在し、それぞれに特性や用途があります。

これらを理解し、適切に選択することで、深層学習モデルの性能を最大限に引き出すことが可能です。

さらに参考してください。